- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:52.

- Modificat ultima dată 2025-01-22 17:38.

In timp ce Scânteie suportă încărcarea fișiere de la local sistem de fișiere, necesită ca fișiere sunt disponibile pe aceeași cale pe toate nodurile din clusterul dvs. Unele sisteme de fișiere de rețea, cum ar fi NFS, AFS și stratul NFS MapR, sunt expuse utilizatorului ca un sistem de fișiere obișnuit.

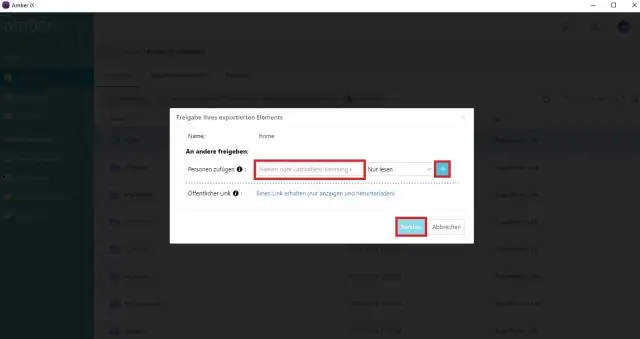

Ulterior, cineva se poate întreba, de asemenea, cum rulez spark în modul local?

În mod local , scânteie locuri de munca alerga pe o singură mașină și sunt executate în paralel folosind multi-threading: acest lucru restricționează paralelismul la (cel mult) numărul de nuclee din mașina dvs. La alerga locuri de muncă în mod local , mai întâi trebuie să rezervați o mașină prin SLURM în interactiv modul și conectați-vă la el.

Alături de mai sus, ce este SC textFile? fisier text este o metodă a unei organizații. apache. SparkContext clasa care citește a fisier text de la HDFS, un sistem de fișiere local (disponibil pe toate nodurile) sau orice URI de sistem de fișiere acceptat de Hadoop și returnați-l ca RDD de șiruri.

În acest sens, ce este un fișier spark?

The Fișier Spark este un document în care îți păstrezi toată bunătatea creativă. A fost definit de autorul Stephen Johnson. Așadar, în loc să zgâriești notițe pe un Post-it® în miezul nopții sau să dedici diferite jurnal pentru idei, îți pui toate conceptele într-unul singur fişier.

Ce este scânteia de colectare paralelizată?

Descriem operațiunile pe seturi de date distribuite mai târziu. Colecții paralele sunt create apelând JavaSparkContext paraleliza metoda pe un existent Colectie în programul dvs. de driver. Elementele de Colectie sunt copiate pentru a forma un set de date distribuit care poate fi operat în paralel.

Recomandat:

Poate Python să citească fișierele ZIP?

Pentru a lucra la fișiere zip folosind python, vom folosi un modul python încorporat numit zipfile. print („Terminat!” ZipFile este o clasă de modul zipfile pentru citirea și scrierea fișierelor zip. Aici importăm doar clasa ZipFile din modulul zipfile

Poate Asistentul Google să-mi citească e-mailurile?

Dacă utilizați aplicația Google Messages pe Android, spuneți Asistentului să vă citească mesajele. De asemenea, puteți trimite e-mailuri în Gmail prin Asistent

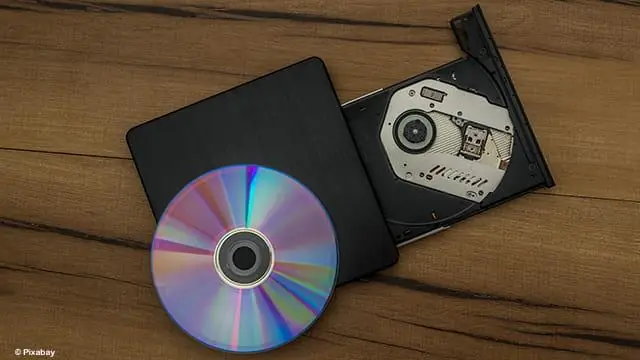

Cum poate un DVD player să citească informațiile stocate pe un DVD?

Un DVD player este foarte asemănător cu un CD player, cu un ansamblu laser care strălucește raza laser pe suprafața discului pentru a citi modelul de denivelări (consultați Cum funcționează CD-urile pentru detalii). Sarcina DVD player-ului este să găsească și să citească datele stocate ca bumps pe DVD

Poate Python să citească fișierele.MAT?

Începând cu versiunea 7.3 a Matlab, fișierele mat sunt de fapt salvate utilizând formatul HDF5 în mod implicit (cu excepția cazului în care utilizați indicatorul -vX la timpul de salvare, vezi în Matlab). Aceste fișiere pot fi citite în Python folosind, de exemplu, pachetul PyTables sau h5py

Poate Windows să citească fișierele HEIC?

Extensia de imagine HEIF permite dispozitivelor Windows 10 să citească și să scrie fișiere care utilizează formatul HighEfficiency Image File (HEIF). Astfel de fișiere pot avea un. heic sau. Dacă pachetul de extensii video HEVC nu este instalat, extensia de imagine HEIF nu va putea citi sau scrie